로지스틱 회귀 (logistic regression)

- 참(1), 거짓(0)을 구분하는 분류 모델

- 로지스틱 회귀 모델을 만들어 YES or NO의 값을 출력하는 것이 딥러닝의 원리

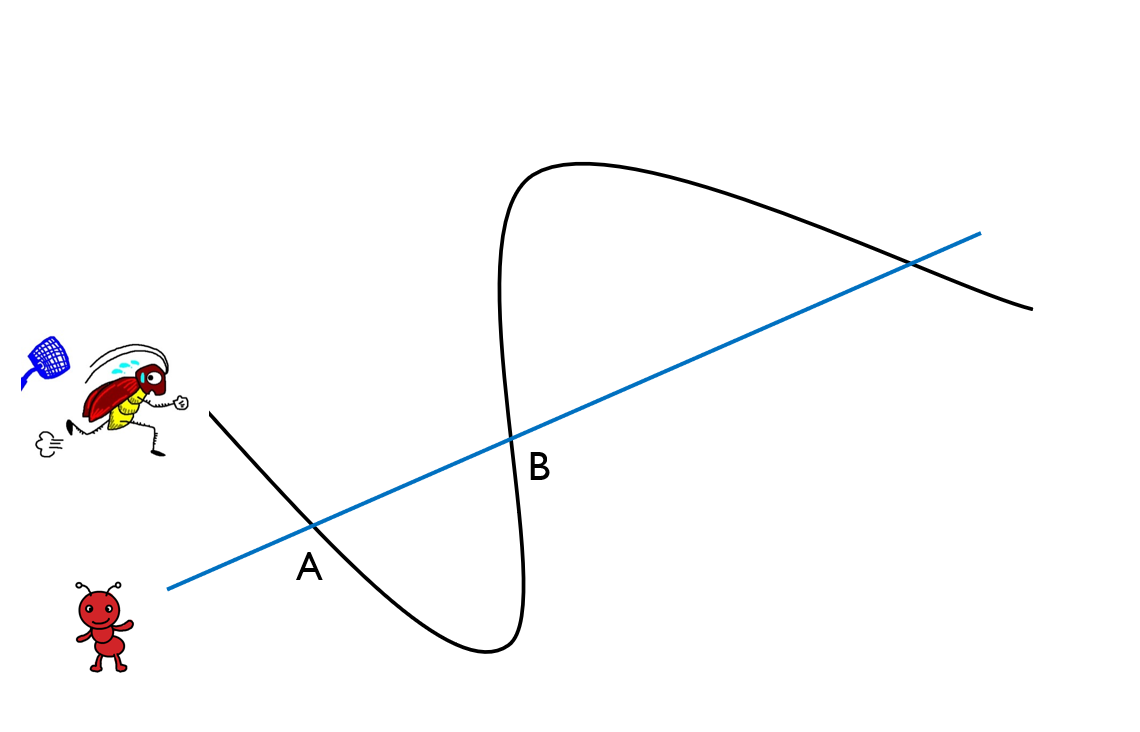

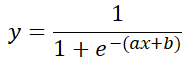

시그모이드 함수 (sigmoid function)

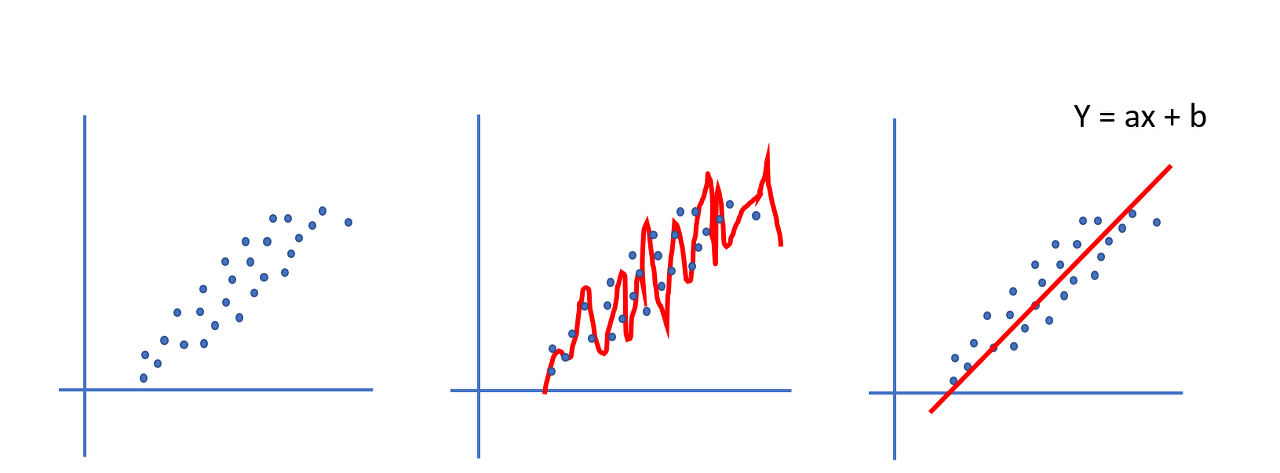

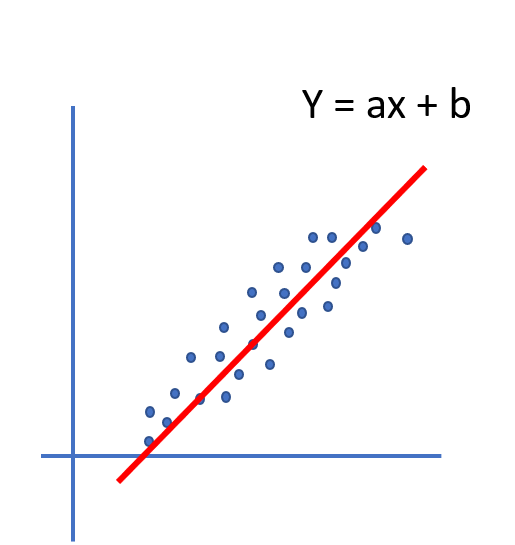

이 함수를 이용해서 구해야 할 값은 ax+b (선형회귀식).

결과값(y)은 0과 1사이

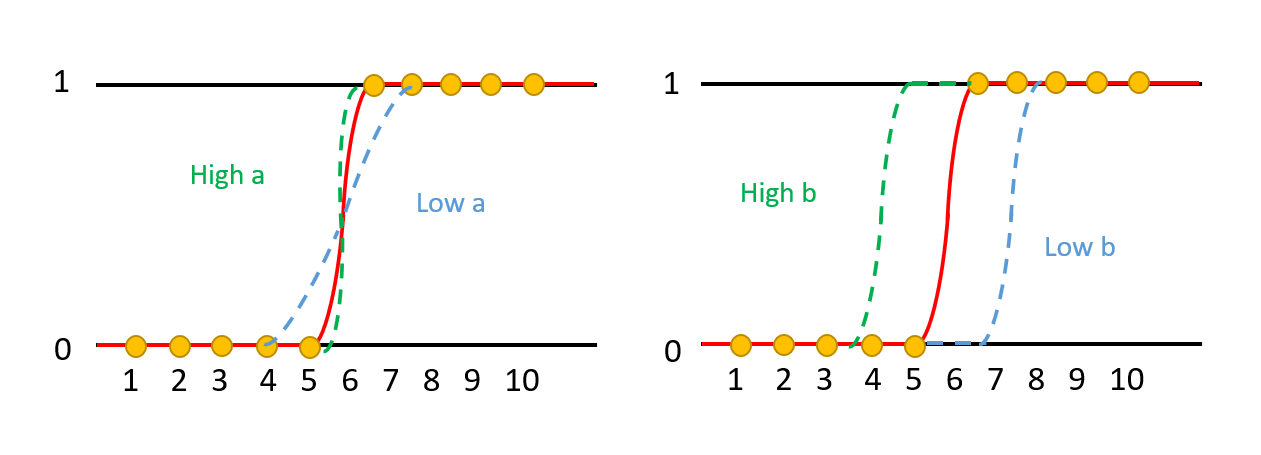

a(그래프의 경사도): a가 커지면 경사가 커지고, a가 작아지면 경사가 작아진다.

b(그래프의 좌우 변위): b가 크면 왼쪽, b가 작으면 오른쪽으로 그래프가 이동함

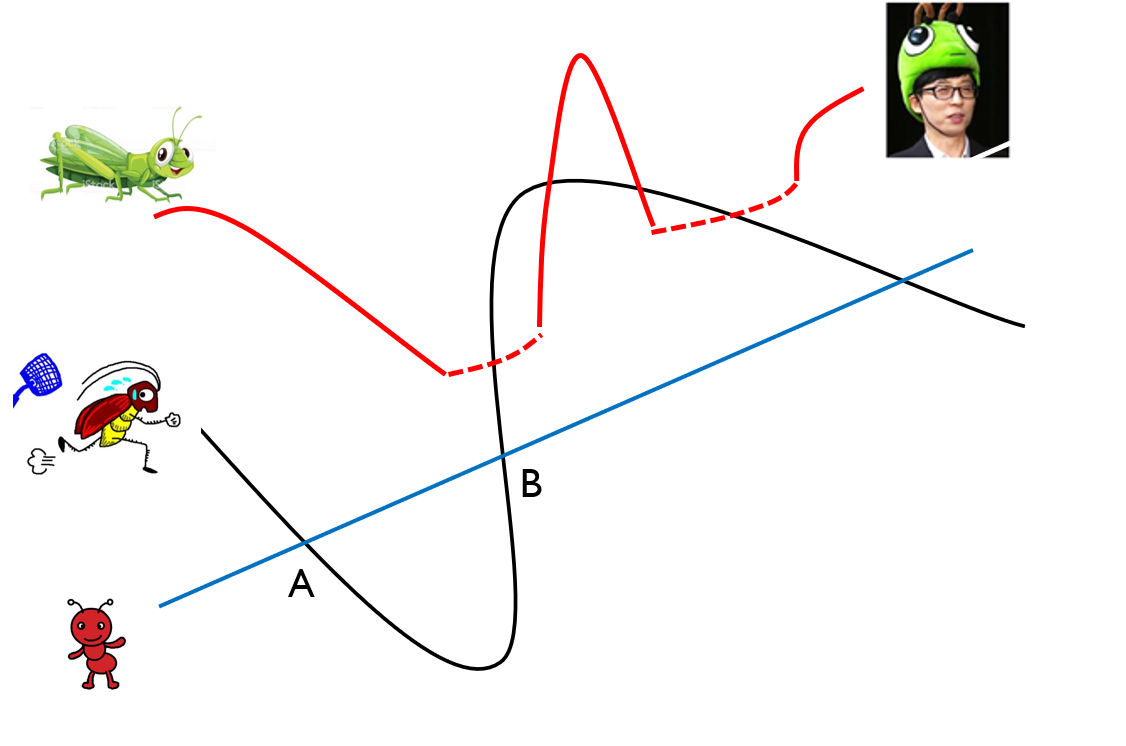

오차 공식

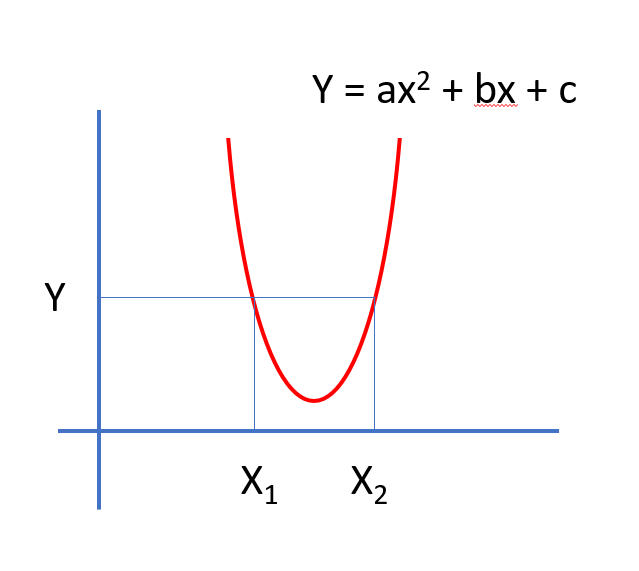

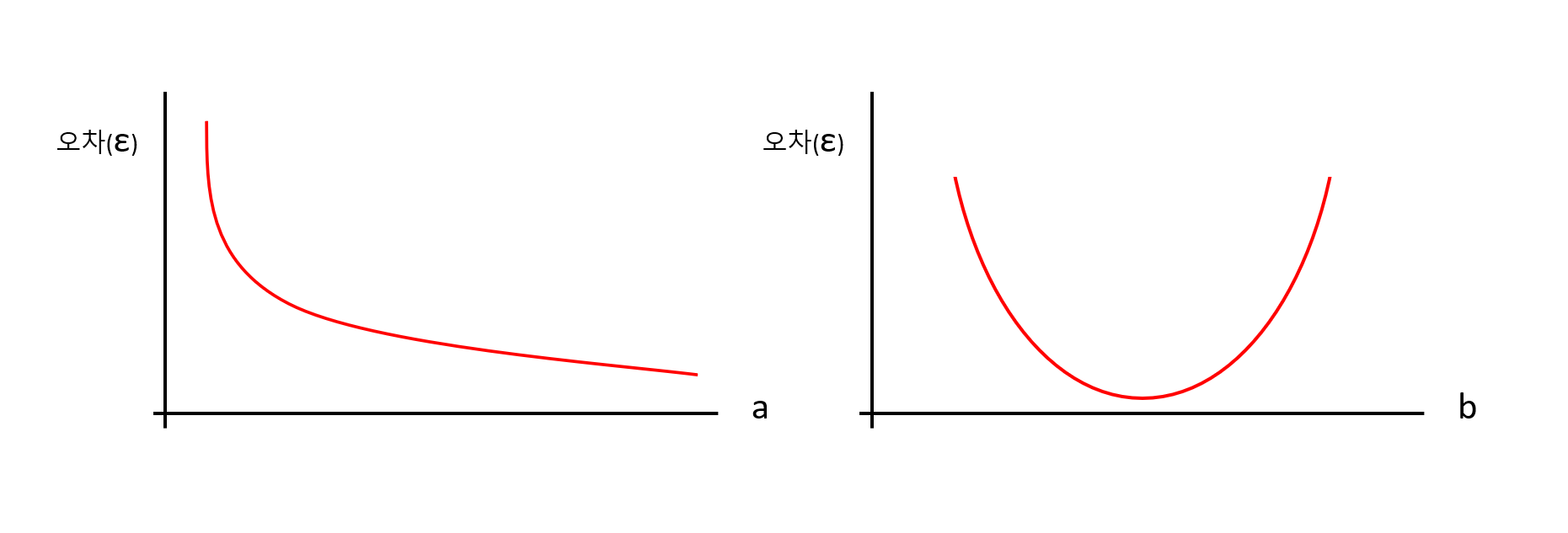

- 시그모이드 함수를 오차를 나타내는 함수로 생각하면, a, b에 따라서 오차가 변한다.

- a가 작아지면 오차는 무한대로 커지나, a가 커지면 오차는 0에 수렴한다.

- b는 너무 크거나 작을 경우, 오차가 증가한다.

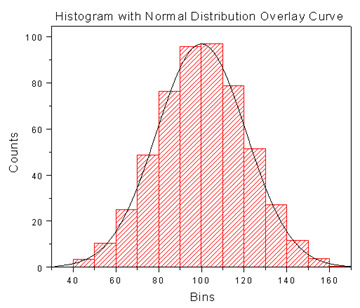

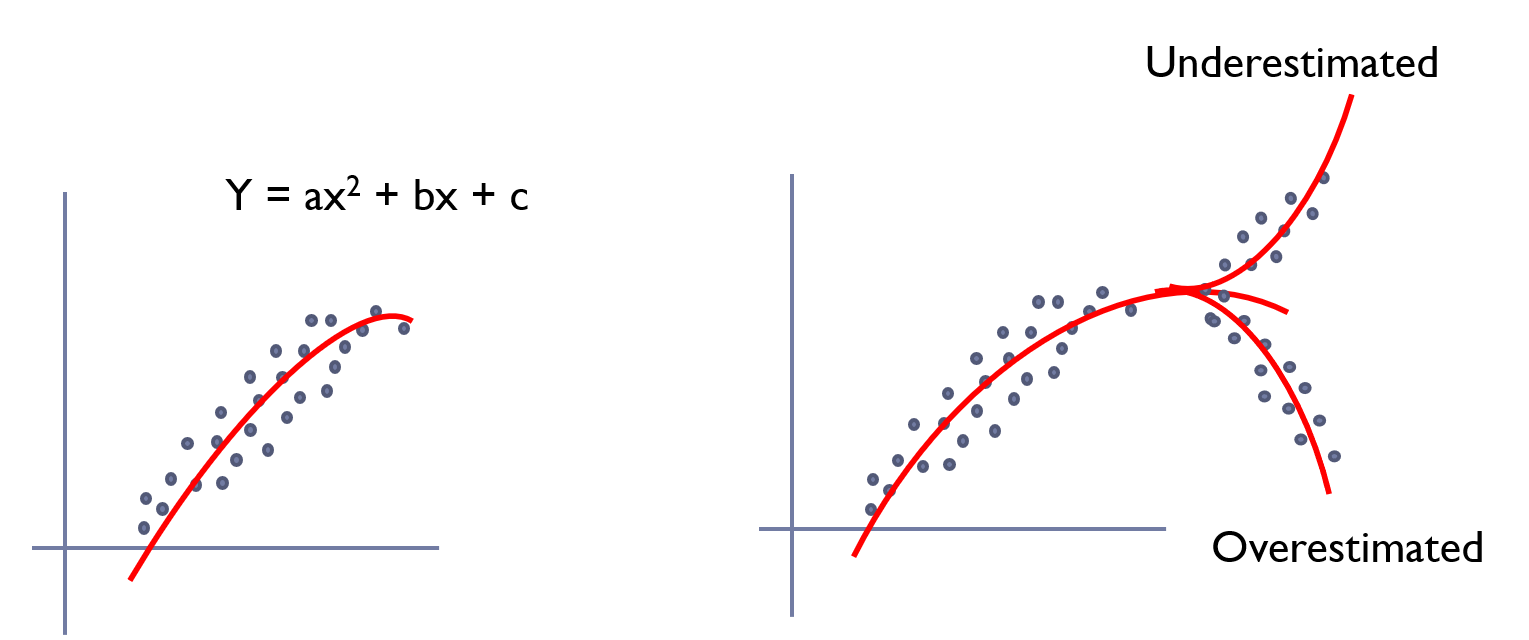

시그모이드 함수 결과값은 [0,1]범위

실제값이 1이고 예측값이 0인 경우: 오차 증가

실제값이 0이고 예측값이 1인 경우: 오차 증가

이 것을 함수로 나타낸 것이 로그 함수.

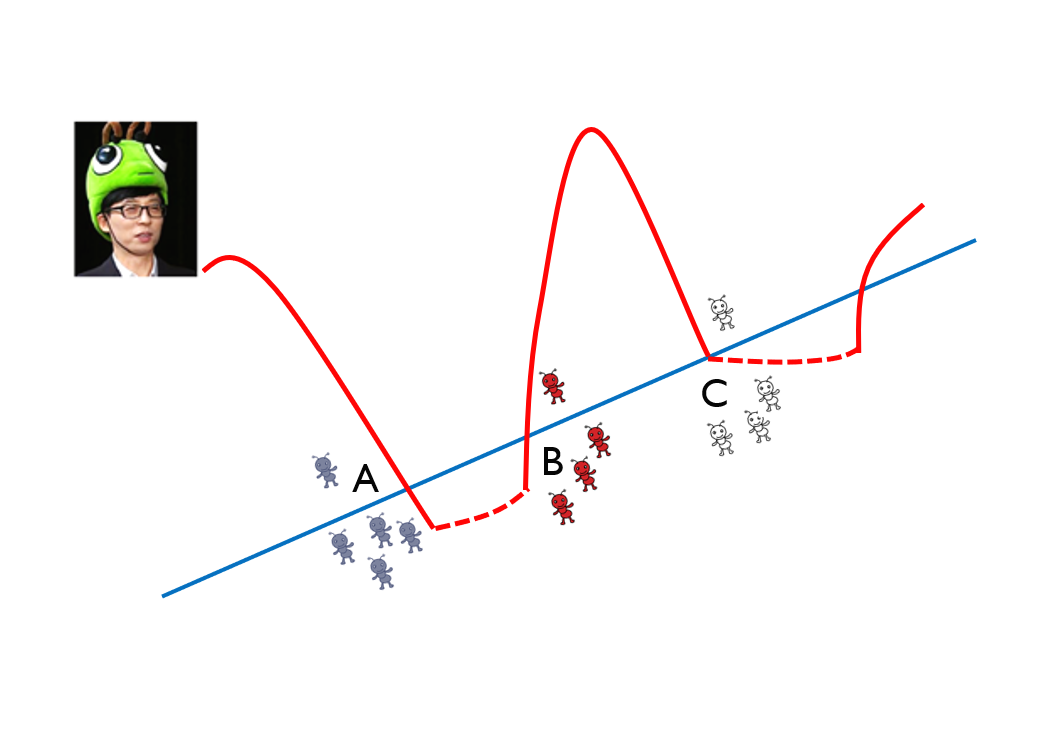

로그함수

그래프에서 y는 실제값

실제값(y)이 1인 경우가 파란색 함수

예측값이 1일 때, 오차는 0

예측값이 0일 때, 오차는 증가

실제값(y)이 0인 경우가 빨간색 함수

예측값이 0일 때, 오차는 0

예측값이 1에 가까울 수록, 오차는 증가

이 것을 통합해서 표현하면 아래 함수로 표현 가능

y(실제값)이 1이면 B부분이 0 --> A만 남아, 파란색 그래프만 사용

y(실제값)이 0이면 A부분이 0 --> B만 남아, 빨간색 그래프만 사용