기상학적 요소의 시공간 분포 관측 및 분석

김O태 (장산중학교 2학년)

김O욱 (오륙도중학교 2학년)

김O연 (센텀중학교 2학년)

윤O은 (광안중학교 2학년)

조O주 (동아중학교 2학년)

초 록

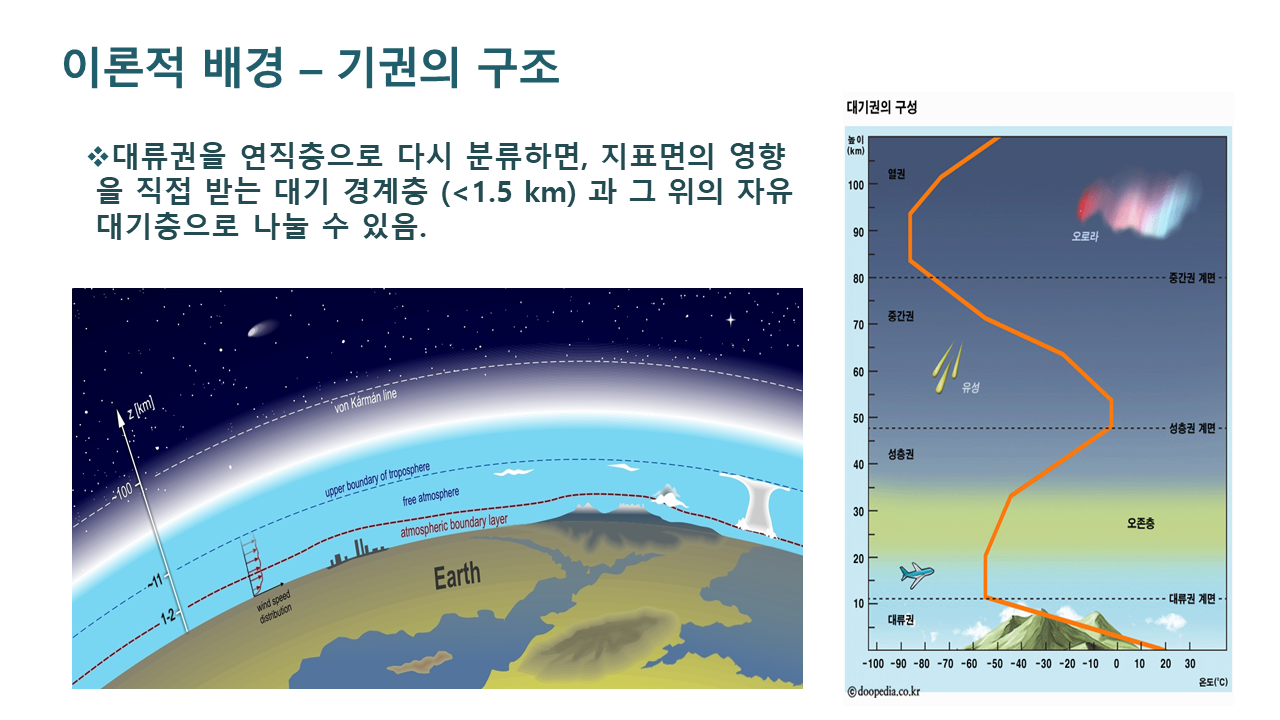

대기의 연직구조의 시공간적 변화의 이해는 기온, 습도, 바람 등 기상요소들의 기상예보를 향상시키는데 매우 중요하다. 예를 들면 겨울과 봄철 대기환경에 가장 큰 영향을 미치는 미세먼지의 발원지를 연직구조를 파악함으로써 역추적할 수 있다. 또한 정확하고 정밀한 기상요소들의 연직관측 자료는 기상 수치모델과 인공위성 알고리즘을 개선하여 궁극적으로 기상예보를 향상시킬 수 있다. 본 연구에서는 표준 기상관측소(창원)에서 실시하는 고층기상관측 외에 수평적으로 약 50 km 떨어진 지점에서 추가적인 고층기상관측을 수행하여, 기상요소들의 고해상도 연직분포를 파악하고자 하였다. 2018년 6월 9일 오전 10시 30분부터 약 1시간 동안 라디오존데를 이용하여, 부산대학교 자연대연구실험동 옥상에서 실험을 수행하였다. 획득된 데이터는 관측지점과 가장 가까운 창원기상대 표준등압면 고층기상관측 자료와 비교 분석하였다. 부양된 라디오존데는 지속적으로 상승하면서, 약 800 hPa 미만의 고도에서 동풍에 의해서 서쪽으로 진행하다 약 750 hPa 상공 이후로 편서풍을 타고 동쪽방향으로 14 km 이동하였다. 라디오존데 고도가 상승함에 따라 기온도 지속적으로 감소하였고, 풍속은 증가, 풍향은 동풍에서 서풍으로 변화하였다. 주풍향은 서풍으로서 창원 기상대 주풍인 서남풍과는 차이를 보였다. 상대습도는 고도에 따라 지속적으로 감소하였는데, 약 2-6 km까지 변하지 않다가 6 km 이후로 8 km 고도까지 증가하는 경향을 보였다. 이는 상공에서 지속적으로 이동 중인 구름과 구름 주변의 수증기의 영향으로 판단된다. 대기의 연직구조에서 가장 중요한 요소 중의 하나인 경계층 고도를 계산하기 위하여, 연직온위분포를 분석였고, 추정한 경계층의 높이는 1.5 km였다.

발표자료 (일부 수정)

참고문헌

- Kang. M., Y.-K. Lim, C. B. Cho, K. R. Kim, J.S. Park, and B.-J. Kim, 2016, Accuracy Assessment of Planetary Boundary Layer Height for the WRF Model Using Temporal High Resolution Radio-sonde Observations, Atmosphere. Korean Meteorological Society, Vol. 26, No. 4 (2016) pp. 673-686

- Kim, K.-H., Y.-H. Kim, and D.-E. Chang, 2009, The Analysis of Changma Structure Using Radiosonde Observational Data from KEOP-2007: Part Ⅱ. 2009b, The Dynamic and Thermodynamic Characteristics of Changma in 2007, Atmosphere, 19(4), 297-307, Atmosphere, 19(4), 297-307

- Kim, K.-H., Y.-H. Kim, and D.-E. Chang, The Analysis of Changma Structure using Radiosonde Observational Data from KEOP-2007: Part I. 2009a, The Assessment of the Radiosonde Data Ki-Hoon Kim, Yeon-Hee Kim* and Dong-Eon Chang, Atmosphere, 19(2), 213-226

- Seo, W.-S. S.-H. Eun, B.-G. Kim, D.-K. Seong, G.-M. Lee, H.-R. Jeon, B.-C. Choi, A.-R Ko, K.-H. Chang, and S.-G. Yang, Intercomparison between Temperature and Humidity Sensors of Radiosonde by Different Manufacturers in the ESSAY (Experiment on Snow Storms At Yeongdong) Campaign, Atmosphere. Korean Meteorological Society, Vol. 26, No. 2 (2016) pp. 347-356

- Sohn, D. H., K. D. Park, Y. H. Kim, 2013, Determination of Precipitable Water Vapor from Combined GPS/GLONASS Measurements and its Accuracy Validation, Journal of the Korean Society for Geospatial Information System, Vol.21 No.4 December 2013 pp. 95-100

- Wallace and Hobbs, 2006, Atmospheric Thermodynamics in Atmospheric Science an Introductory survey, Academic Press.

부 록

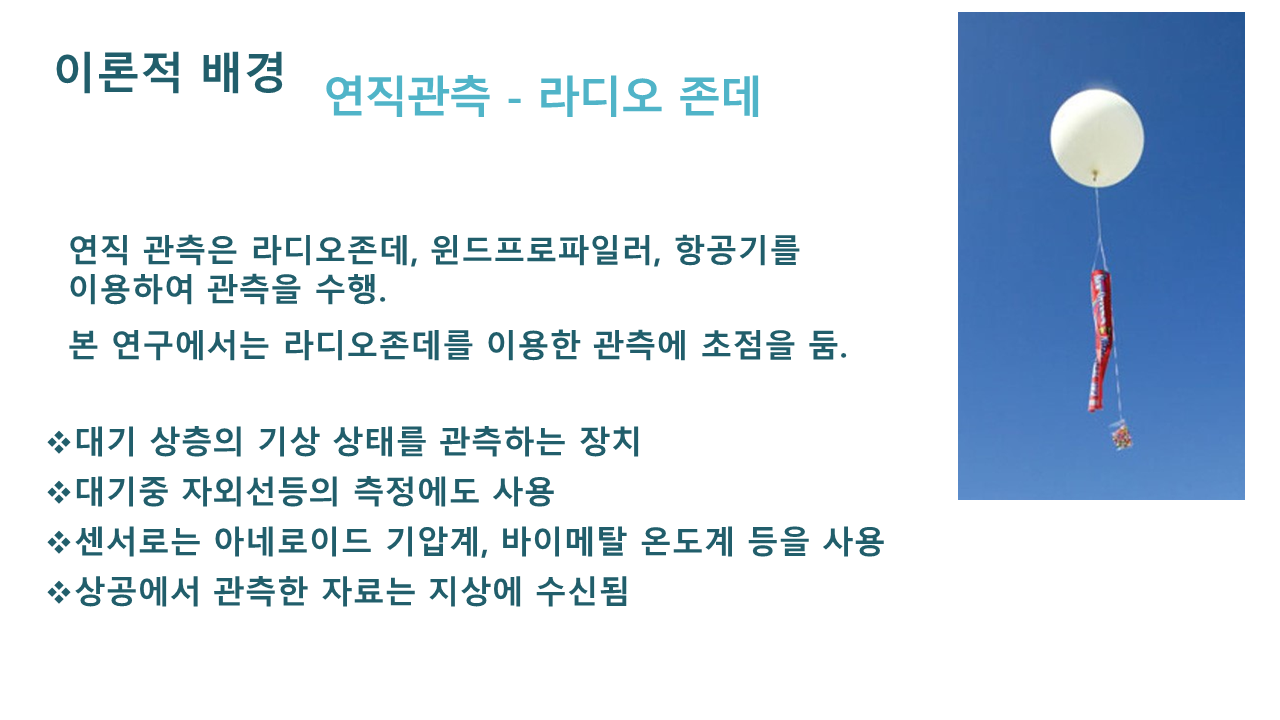

1. 라디오존데

1892년 프랑스 과학자 귀스타브 에르미트가 데이터를 수집하기 위해 최초로 실크 풍선을 이용하여 사용하였다. 이후 1901년 실크 풍선은 고무풍선으로 교체되었다. 20킬로미터 상공에 도달하며 풍선이 터지면 기상 관측 기구인 라디오존데는 낙하산에 매달린 채 지상으로 떨어지는데, 떨어진 라디오존데를 찾는 것은 순전히 운에 달려 있었다.제1차 세계대전 중, 군대는 라디오존데를 통한 더 많은 데이터를 필요로 했었는데, 저렴하고 가벼우면서도 신뢰할 수 있는 무선 시스템이자 온도, 기압, 습도를 무선 신호로 변조할 수 있는 라디오존데는 1930년대가 되어서야 쓰이기 시작하였다. 라디오존데는 러시아의 파벨 몰차노프가 개발하였으며 수많은 나라의 기상청에서 빠르게 채택되었다.

과거 라디오존데에는 기압 관측은 아네로이드기압계, 기온 관측은 바이메탈온도계, 습도 관측은 산화알루미늄 피막으로 된 습도계를 사용하였다. 하지만, 요즘은 전자식 센서를 사용한다. 관측기계는 5 ㎧의 속도로 상승하는 기구에 실려 20∼30 ㎞의 상공에 이르기까지 관측과 송신을 계속하면서 고도별 기압·기온·습도·풍향·풍속을 관측한다. 측정값은 모스부호를 사용하는 부호식이나 주파수 변조방식을 사용하여 발신하고, 지상에서는 수신기를 통해 라디오존데가 관측한 자료를 받는다.

2. Graw 라디오존데를 이용한 관측실험 방법

■ 장소: 부산대학교 옥상

■ 일시: 2018. 6. 9. 토요일 AM 10:30~11:30

■ 준비물: 헬륨 봄베(47L), 풍선, 라디오존데(센서, GPS), 수신기, 노트북

- 라디오존데는 풍선 형태의 기상 관측 기구로 고도에 따라 진행방향, 온위, 풍향, 풍속을 측정하였고, 독일 Graw사의 수신기(403.6Hz 주파수대)와 Grawmet 프로그램을 이용.

- 수신기는 독일 회사인 Graw 이용하였으므로 노트북에는 Grawmet 프로그램이 필요. GPS를 이용하여 축정한 풍향, 풍속 값이나 기압, 온도 등 각종 센서에서 측정한 데이터가 뜬다

- 풍선은 안쪽이 실로 터지지 않게 처리되어 있거나 이중으로 겹이 되어 있는 800g 들이 풍선을 사용하나 이 실험에서는 200g들이를 사용

■ 실험방법

① 노트북으로 프로그램을 켠다.

② 존데와 노트북을 연결하여 값을 초기화시킨다.

③ 기상 정보를 입력한다. 측정하고 있는 장소의 온도, 습도를 라디오존데가 측정하며, 풍향, 풍속 역시 입력해야 한다. (풍향 동 90, 풍속 1.8m/s)

*프로그램에는 Sounding 과 Simulation 버튼이 뜨는데, 이때 Sounding은 실제 실험을 할 때 이용한다.

*라디오존데는 400~406Hz까지 이용할 수 있다. (403.6Hz 이용)

④ 라디오존데가 보내는 값 중 어떤 정보를 띄울 것인지 결정한다.

*가공된 값, 미가공 값, 그래프가 있다. 가공된 그래프는 존데가 날아간 후 뜨고, 온도, 습도, GPS값은 미가공 값이다. 이때 GPS는 주변에 총 4개 이상이 있어야 안정적인 풍향, 풍속 정보를 받을 수 있다.

⑤ 풍선에 헬륨을 넣는다. *갑자기 세게 열 경우 봄베에서 헬륨이 한꺼번에 많이 빠져나와 빙글빙글 돌게 되기 때문에 사고에 주의해야 한다.

⑥ 존데를 실로 풍선에 묶어 날려 보낸다. *라디오존데를 묶기 전 캡을 씌워야 물기가 들어가 잘못된 값이 나오는 것을 막을 수 있다. 이때, 센서는 캡 밖으로 빼서 날리고, 보관할 때는 안으로 넣어서 보관한다.

⑦ 존데가 보내는 값들을 살펴본다. 화면 왼쪽에 뜨는 고도를 보고 현재 풍선이 어디까지 날아갔는지를 알 수 있다. 풍선이 하나밖에 없었기 때문에 실을 하나 더 매달아서 붙잡고 있어야 했다. 그러나 세 번째로 날려 보냈을 때 실이 끊어져서 8000m까지 올라가는 것을 볼 수 있었다.