728x90

반응형

기울기 소실 문제(vanishing gradient)

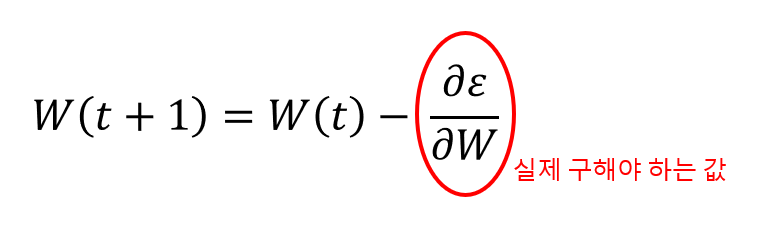

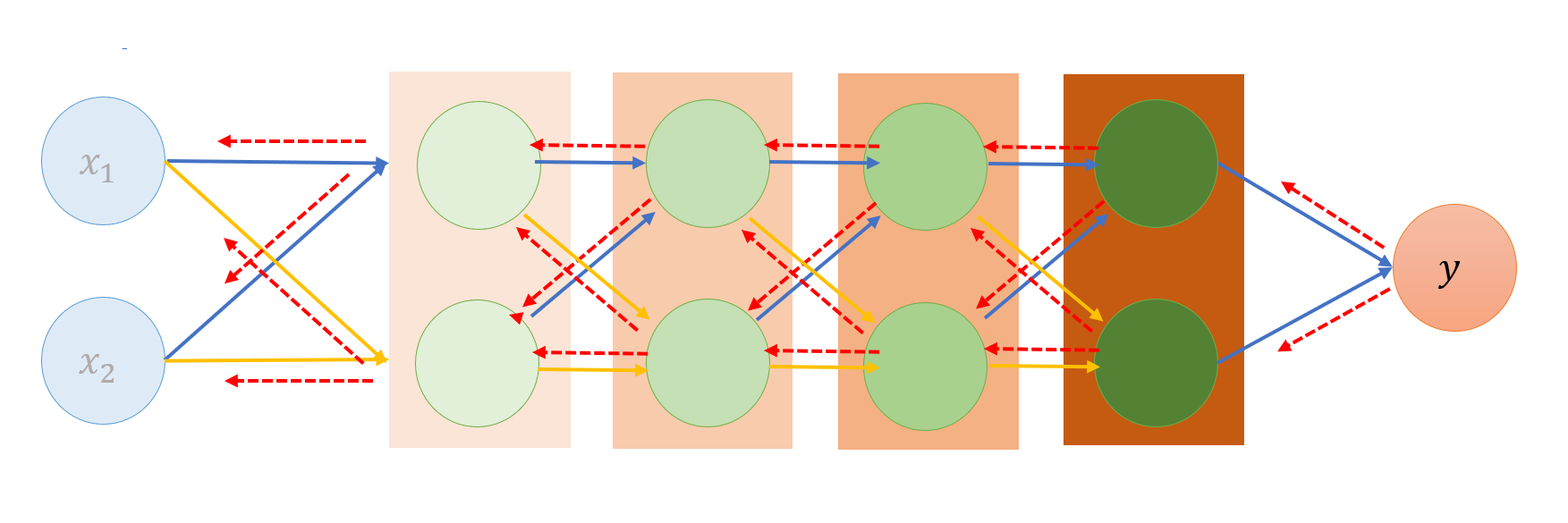

- 출력층에서 은닉층을 역방향으로 하나씩 진행하며, 각 층(은닉층, 입력층)의 가중치를 수정하는 방법

- 가중치 수정을 위해서는 미분값(기울기)가 필요

- 층의 갯수가 늘어나면, 역전파를 통해 전달되는 기울기 값이 점점 작아져, 맨 처음층(입력층)까지 도달하지 않는 문제가 발생... 기울기 소실 문제(vanishinig gradient)

- 활성화 함수(시그모이드 함수)의 특징 때문에, 여러 층을 거칠 수록 기울기가 사라져서 가중치 수정이 어려워짐.

활성화 함수

1. Sigmoid 함수

- 미분하면 최대치가 < 1.0 따라서, 계속 곱하면 0에 수렴.... 기울기 소실 발생

2. tanh 함수

- 시그모이드 함수 확장형 [-1,1]

- 1보다 작은 값이 존재하므로, 기울기 소실 발생

기울기 소실 문제를 해결하기 위해서 새로운 활성화 함수가 필요.

3. ReLU 함수

- 0보다 작을때 0으로 처리, 0보다 클때 x값을 그대로 사용 ... 기울기 소실 해결

4. Softplus 함수

- ReLU함수에서 0보다 작은 경우를 완화한 함수... 기울기 소실 해결

그 외 다양한 활성화 함수

Activation Functions : Sigmoid, ReLU, Leaky ReLU and Softmax basics for Neural Networks and Deep…

Let’s start with the basics why would we even need an activation function and what is it >

himanshuxd.medium.com

728x90

반응형